Desvendando a GenAI - Parte 8

Neste post, abordamos dois conceitos fundamentais para o uso de LLMs: Fine Tuning e Embedding.

LLM Fine Tuning: Otimizando Modelos para Necessidades Específicas

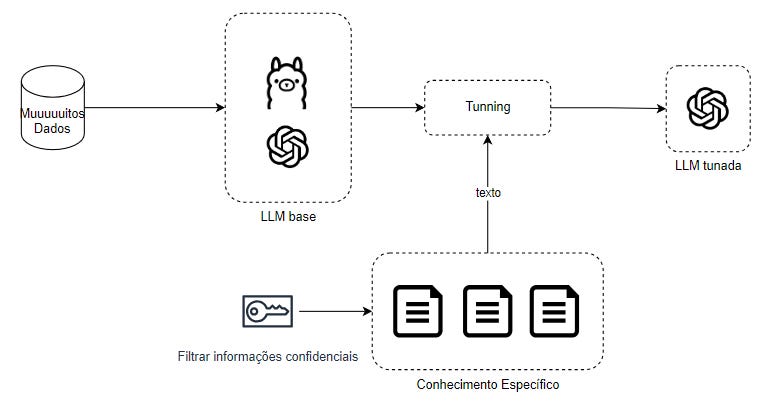

Fine tuning consiste em ajustar um modelo de linguagem já treinado (LLM base) para atender a necessidades específicas de um domínio. Isso é feito através de um processo adicional de treinamento com dados especializados e filtrados, como informações confidenciais ou termos técnicos de uma indústria.

Vantagens:

Personalização: Permite ajustar o modelo para tarefas específicas, melhorando sua precisão.

Desempenho: O modelo responde com maior relevância a consultas do domínio treinado.

Autonomia: Um modelo ajustado opera de forma independente, sem necessidade de muita inferência adicional.

Desvantagens:

Custo de Treinamento: Requer recursos computacionais significativos.

Atualização Constante: Pode se tornar desatualizado rapidamente se o domínio de atuação for dinâmico.

Overfitting: O treinamento excessivo pode limitar a generalização do modelo para dados novos.

Precisa de conhecimento específico (um cientista de dados, por exemplo) para realizar o finetuning.

Além disso, para que o fine tuning seja eficaz, os dados precisam ser de alta qualidade e contextualizados.

Exemplo de aplicação de Fine Tuning: Assistente Técnico para Manutenção de Máquinas

Cenário:

Uma empresa de manufatura opera com máquinas complexas, como prensas hidráulicas e tornos CNC. A equipe de manutenção frequentemente consulta manuais técnicos ou solicita ajuda de especialistas para diagnosticar problemas e realizar reparos. Esse processo pode ser demorado e propenso a erros.

Solução com Fine Tuning:

Criar um assistente técnico baseado em um modelo de linguagem ajustado (fine-tuned) para oferecer suporte automatizado à equipe de manutenção.

Coleta de Dados:

São coletados manuais técnicos, logs de manutenção, instruções de reparos e relatórios de falhas anteriores.

Os dados são organizados e filtrados, destacando procedimentos padrão, códigos de erro e informações sobre peças específicas.

Treinamento do Modelo:

Um modelo base, como GPT-4, é ajustado com os dados coletados.

O treinamento inclui exemplos específicos, como:

Diagnóstico de falhas: “O motor da prensa está superaquecendo e exibindo o código de erro E102.”

Procedimentos de manutenção: “Como substituir o filtro hidráulico da prensa modelo X200?”

Implementação:

O modelo ajustado é integrado a um sistema de consulta (como um aplicativo ou painel digital) disponível para os técnicos.

Resultados:

Diagnóstico Rápido: Um técnico pode descrever o problema e receber uma resposta imediata:

“O código de erro E102 indica superaquecimento do motor. Verifique o nível do óleo e a condição do sistema de resfriamento. Substitua o filtro se necessário.”

Manutenção Preventiva: O assistente pode sugerir verificações regulares com base nos dados históricos, como:

“Recomenda-se inspecionar a correia transportadora da máquina X200 a cada 500 horas de operação.”

Sugestões de Peças: O modelo fornece informações sobre peças específicas e fornecedores:

“Para substituir o filtro hidráulico, utilize o modelo FH-300. Estoque disponível no armazém 2.”

Embedding: Representações Semânticas Compactas

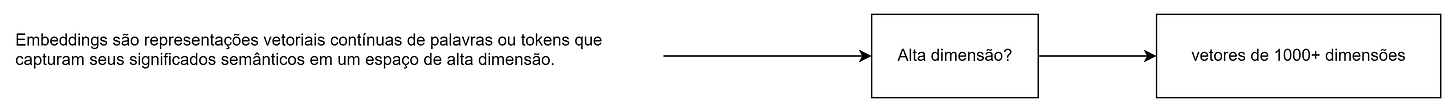

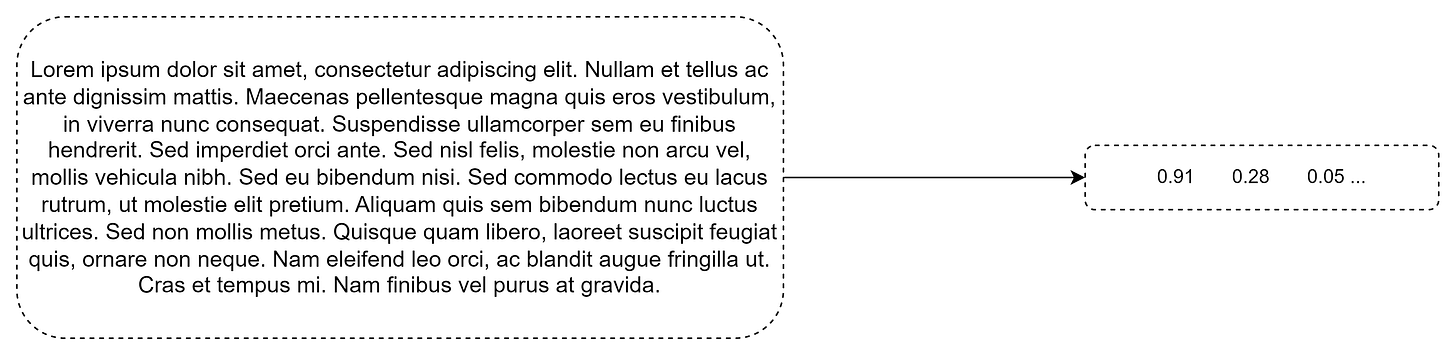

O embedding transforma textos ou palavras em representações vetoriais de alta dimensão, permitindo que informações semânticas sejam capturadas. Na prática, cada texto ou termo é mapeado em vetores numéricos que representam suas relações no espaço semântico.

Por exemplo, ao processar um parágrafo, o embedding gera vetores que traduzem o contexto de cada termo em números. Isso possibilita aplicações como chatbots, mecanismos de busca avançados e análise de sentimentos.

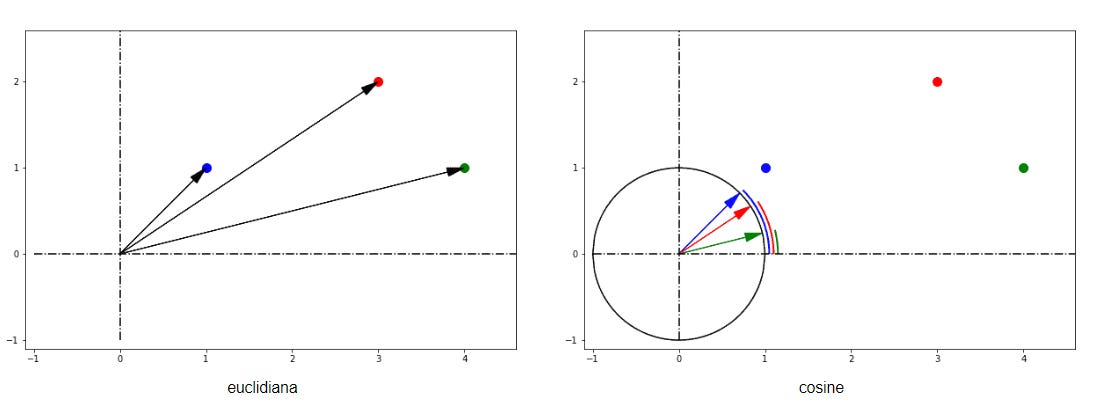

Mas como esses vetores são úteis? Através dos vetores, é possível calcular a distância vetorial, que mede o quão distante um texto está do outro. Essa distância pode indicar o grau de similaridade entre os textos, ou seja, se eles tratam do mesmo assunto. Como os embeddings têm a capacidade de extrair o contexto, eles são extremamente úteis para comparar textos.

Mas como calculo essa distância? Quem lembra da distância euclidiana, pois é… Existem outras…

Seguem alguns exemplos de distância vetoriais e suas aplicações:

L2 distance (distância euclidiana): Classificação de texto, geralmente funciona melhor sob distâncias euclidianas.

L1 distance (distância manhattan): A distância euclidiana é mais sensível às diferenças de magnitude entre as dimensões, enquanto a distância de Manhattan é menos sensível a essas diferenças e pode ser preferível quando as dimensões têm unidades ou escalas diferentes.

Cosine distance: Recuperação dos textos mais semelhantes a um dado documento, geralmente funciona melhor com similaridade de cosseno. "Ela captura significado... Não números"

Haaming distance: a similaridade de cosseno produzirá um indicador mais forte quando dois documentos tiverem a mesma palavra várias vezes, enquanto a distância de Hamming não se importa com a frequência com que os tokens individuais aparecem.

Jaccard distance: A similaridade de cosseno é mais adequada para dados aproximados, enquanto a similaridade de Jaccard é melhor para dados exatos.

Inner product (produto interno): A similaridade do cosseno é proporcional ao produto escalar (produto interno) de dois vetores e inversamente proporcional ao produto de suas magnitudes. Ou seja, o produto interno leva em consideração a magnitude.

Casos de Uso:

Busca Semântica: Sistemas que retornam resultados mais relevantes com base no significado.

Análise de Similaridade: Comparação entre textos para identificar padrões ou redundâncias.

Classificação: Organização de informações complexas em categorias.

Conclusão

Tanto o fine tuning quanto o embedding são ferramentas importantes para maximizar o potencial dos modelos de linguagem em aplicações práticas. Enquanto o fine tuning possibilita a personalização para atender necessidades específicas de um domínio, o embedding oferece uma base poderosa para análise semântica e organização de informações complexas. Juntos, esses conceitos ajudam a transformar dados em soluções inteligentes e eficientes.

O futuro dos LLMs está na integração cada vez mais personalizada e estratégica, levando organizações a novos patamares de eficiência e produtividade.

No próximo post iremos implementar estes dois conceitos! Fique de olho!